Sistema de algoritmo que determina se alguém vai para a cadeia cria polêmica nos EUA

Um sistema que usa algoritmos matemáticos vem sendo usado no Estado americano do Wisconsin para determinar o grau de periculosidade de criminosos, num processo que acabaria por influenciar as suas penas.

Afinal, seriam esses algoritmos capazes de tornar as sentenças mais justas?

Os problemas do sistema penitenciário do Estado do Wisconsin foram tema do documentário da Netflix Making a Murderer ("Fabricando um assassino", em tradução livre).

O documentário mostra a condenação de um inocente que passou 18 anos na cadeia.

- Seriado gera campanha para libertar condenado por homicídio

- 'Como passei 21 dias na prisão por causa de um documento roubado'

Mas agora, um outro caso coloca em xeque a Justiça do Estado.

Nas primeiras horas do dia 11 de fevereiro de 2013, uma segunda-feira, dois tiros foram disparados numa casa na cidadezinha de La Crosse, no Wisconsin.

Uma testemunha disse que os tiros haviam partido de um carro, que foi perseguido pela polícia. Os dois ocupantes acabaram presos.

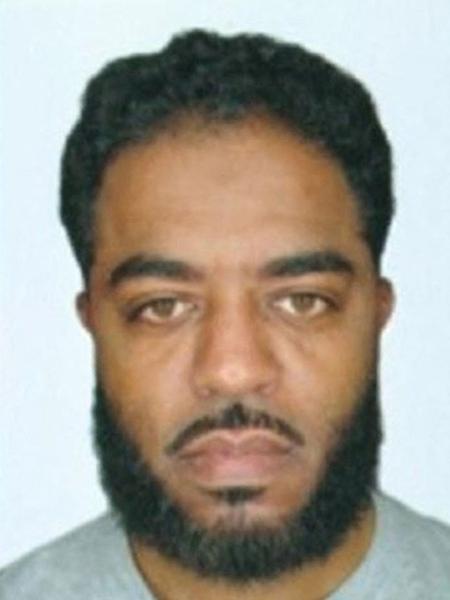

Um deles, Eric Looms, confessou que estava dirigindo, mas negou ter feito os disparos.

Loomis foi condenado a seis anos de prisão - sentença calculada com a ajuda de um algoritmo matemático.

Ao decidir pela prisão de Loomis, o tribunal destacou que ele tinha sido classificado como um "indivíduo que representa alto risco para a comunidade".

Pelo menos esse foi o resultado do questionário que ele respondeu no momento da detenção.

Sistema de pontos

O questionário é conhecido como Compas (sigla em inglês para Correctional Offender Management Profiling for Alternative Sanctions).

"O Compas faz várias perguntas que avaliam o quanto você pode ser capaz de voltar a cometer um crime futuramente."

"Essa avaliação se baseia num sistema de pontos, de um a 10", explica Julia Angwin, da ProPublica, organização americana independente dedicada ao jornalismo investigativo.

Ela conta que as perguntas procuram saber, por exemplo, "se alguém na família foi preso, se a pessoa vive numa área com alto índice de criminalidade, se tem amigos que fazem parte de gangues, assim como o seu histórico profissional e escolar."

"Por último, são feitas perguntas sobre o que chamam de pensamentos criminosos. Por exemplo, se a pessoa concorda ou não com a afirmação: é aceitável que alguém que passa fome roube", diz Julia.

A avaliação pode ser usada então para decidir se a pessoa vai ser solta com pagamento de fiança, se deve ser mandada para a prisão ou receber outro tipo de sentença e - se já estiver na cadeia - se tem direito a liberdade condicional.

O Compas e um software parecido com ele estão sendo utilizados em todos os EUA.

A intenção é tornar as decisões judiciais menos subjetivas - menos influenciáveis por erros humanos, preconceitos ou racismo.

O segredo do algoritmo

Mas uma informação importante é mantida em segredo: como o algoritmo matemático transforma as respostas em pontos de um a 10.

"Não sabemos como a classificação é criada a partir das respostas porque o algoritmo é propriedade de uma empresa e esse é um segredo comercial", continua Julia Angwin.

E isso torna mais difícil para o réu questionar o resultado.

"Como você vai dizer que na verdade sua pontuação é oito ou sete quando não sabe como isso foi calculado?"

Foi partindo desse princípio que Loomis contestou o uso da tabela Compas para o cálculo da sua condenação.

Mas em julho passado, a Suprema Corte de Wisconsin concluiu que se o método for usado corretamente, não há desrespeito aos direitos do acusado.

A Suprema Corte também determinou que futuramente a avaliação de risco deve ser acompanhada de uma explicação sobre as suas limitações.

Uma das explicações é que o algoritmo é sigiloso e que a tabela de risco se baseia em traços gerais de comportamento.

Minorias étnicas têm pontuação maior

A Suprema Corte de Wisconsin advertiu ainda que o Compas pode dar uma pontuação consideravelmente maior para infratores de minorias étnicas.

Uma falha séria, especialmente num momento em que as ações policiais nos EUA têm agravado tensões raciais.

Essas ressalvas foram feitas a partir de uma investigação de Julia e seus colegas da ProPublica sobre a precisão do Compas.

A análise das pontuações de sete mil pessoas presas em uma determinada região do estado da Flórida durante dois anos chegou a um resultado surpreendente.

"Quando analisamos um acusado negro e outro branco com a mesma idade, sexo e ficha criminal - e levando em conta que depois de serem avaliados os dois cometeram quatro, dois ou nenhum crime -, o negro tem 45% mais chances do que o branco de receber uma pontuação alta", afirma Julia Angwin.

Mas como o algoritmo produz resultados assim se não há no questionário um item específico sobre raça?

A pesquisadora diz que "o algoritmo, no entanto, analisa perguntas que podem ser consideradas representativas de situações raciais. Por exemplo: alguém na sua família foi preso? Quantas vezes você foi preso?"

"Este tipo de informação costuma valer mais para minorias étnicas do que para a população branca".

Não por acaso as conclusões da ProPublica têm causado muito debate nos EUA, especialmente no que diz respeito ao uso da classificação de periculosidade.

Preconceito racial em debate

A empresa que criou o Compas rejeita a relação entre preconceito racial e os resultados obtidos pelo algoritmo.

Além disso, três pesquisadores independentes divulgaram um documento colocando em dúvida os métodos da ProPublica.

O chefe da pesquisa é Anthony Flores, professor assistente do departamento de Direito Penal da Universidade do Estado da Califórnia, em Bakersfield, EUA.

O professor diz que os algoritmos já provaram ser melhores que os juízes para prever se uma pessoa vai voltar a cometer um crime.

Ele afirma que a ProPublica interpretou mal o que os dados mostraram.

"Não encontramos qualquer preconceito de nenhum tipo quando revisamos os dados", acrescenta Flores.

Ele acusa a ProPublica de usar diferentes metodologias até chegar a conclusão que desejava. "Não discordamos das descobertas, apenas da conclusão."

A BBC consultou especialistas em estatística não envolvidos nesse debate.

Eles afirmam que existem outras formas de analisar o mesmo tipo de dados sem que isso implique em preconceito racial.

Mas todos parecem concordar que se, em geral, os negros têm maior probabilidade de voltar a cometer uma infração, então um acusado negro possivelmente vai receber uma pontuação maior na avaliação.

O algoritmo em si pode não ter um viés racial, mas está expondo mais claramente os preconceitos raciais do sistema penal e da sociedade nos EUA.

Julia Angwin afirma que isso merece reflexão.

"Se estamos tratando de algo que tem a ver com a liberdade das pessoas, temos o dever de fazer isso corretamente", observa.

"Queremos penalizar ainda mais os réus negros por viverem em áreas pobres e terem o que esse algoritmo considera atributos de maior periculosidade apesar de essas pessoas não serem perigosas?"

"Ou estamos querendo usar esse sistema porque achamos que ele permite que todo mundo receba um tratamento justo?"

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.