Algoritmos das rede sociais promovem preconceito e desigualdade, diz matemática de Harvard

Eles estão por toda parte. Nos formulários que preenchemos para vagas de emprego. Nas análises de risco a que somos submetidos em contratos com bancos e seguradoras. Nos serviços que solicitamos pelos nossos smartphones. Nas propagandas e nas notícias personalizadas que abarrotam nossas redes sociais. E estão aprofundando o fosso da desigualdade social e colocando em risco as democracias.

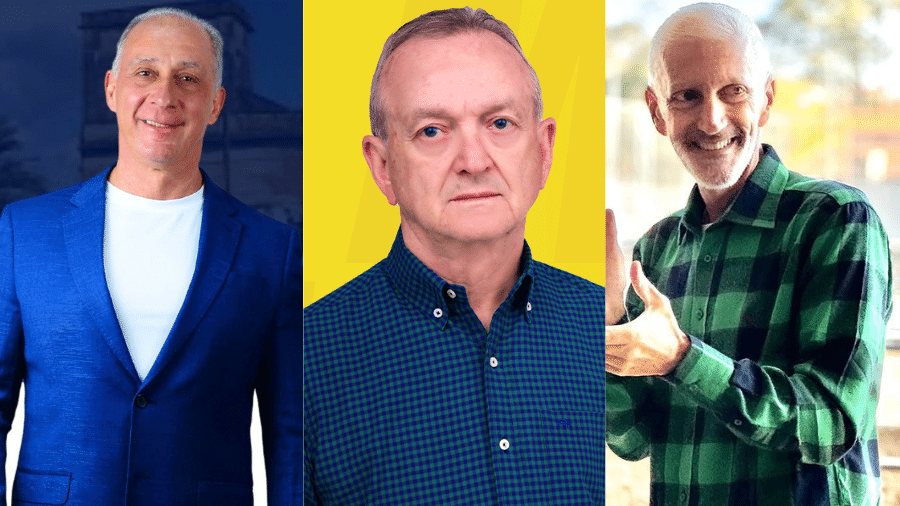

Definitivamente, não é com entusiasmo que a americana Cathy O'Neil enxerga a revolução dos algoritmos, sistemas capazes de organizar uma quantidade cada vez mais impressionante de informações disponíveis na internet, o chamado Big Data.

Matemática com formação em Harvard e Massachussetts Institute of Technology (MIT), duas das mais prestigiadas universidades do mundo, ela abandonou em 2012 uma bem-sucedida carreira no mercado financeiro e na cena das startups de tecnologia para estudar o assunto a fundo.

- Os argumentos das católicas brasileiras que há 25 anos defendem o aborto

- Por que a venda de armas no mundo cresceu pela primeira vez em 5 anos

Quatro anos depois, publicou o livro Weapons of Math Destruction (Armas de Destruição em Cálculos, em tradução livre, um trocadilho com a expressão "armas de destruição em massa" em inglês) e tornou-se uma das vozes mais respeitadas no país sobre os efeitos colaterais da economia do Big Data.

A obra é recheada de exemplos de modelos matemáticos atuais que ranqueiam o potencial de seres humanos como estudantes, trabalhadores, criminosos, eleitores e consumidores. Segundo a autora, por trás da aparente imparcialidade desses sistemas, escondem-se critérios nebulosos que agravam injustiças.

É o caso dos seguros de automóveis nos Estados Unidos. Motoristas que nunca tomaram uma multa sequer, mas que tinham restrições de crédito por morarem em bairros pobres, pagavam valores consideravelmente mais altos do que aqueles com facilidade de crédito, mas já condenados por dirigirem embriagados. "Para a seguradora, é um ganha-ganha. Um bom motorista com restrição de crédito representa um risco baixo e um retorno altíssimo", exemplifica.

Confira abaixo os principais trechos da entrevista:

BBC Brasil - Há séculos pesquisadores analisam dados para entender padrões de comportamento e prever acontecimentos. Qual é novidade trazida pelo Big Data?

Cathy O'Neil - O diferencial do Big Data é a quantidade de dados disponíveis. Há uma montanha gigantesca de dados que se correlacionam e que podem ser garimpados para produzir a chamada "informação incidental". É incidental no sentido de que uma determinada informação não é fornecida diretamente - é uma informação indireta. É por isso que as pessoas que analisam os dados do Twitter podem descobrir em qual político eu votaria. Ou descobrir se eu sou gay apenas pela análise dos posts que curto no Facebook, mesmo que eu não diga que sou gay.

A questão é que esse processo é cumulativo. Agora que é possível descobrir a orientação sexual de uma pessoa a partir de seu comportamento nas redes sociais, isso não vai ser "desaprendido". Então, uma das coisas que mais me preocupam é que essas tecnologias só vão ficar melhores com o passar do tempo. Mesmo que as informações venham a ser limitadas - o que eu acho que não vai acontecer - esse acúmulo de conhecimento não vai se perder.

BBC Brasil - O principal alerta do seu livro é de que os algoritmos não são ferramentas neutras e objetivas. Pelo contrário: eles são enviesados pelas visões de mundo de seus programadores e, de forma geral, reforçam preconceitos e prejudicam os mais pobres. O sonho de que a internet pudesse tornar o mundo um lugar melhor acabou?

O'Neil - É verdade que a internet fez do mundo um lugar melhor em alguns contextos. Mas, se colocarmos numa balança os prós e os contras, o saldo é positivo? É difícil dizer. Depende de quem é a pessoa que vai responder. É evidente que há vários problemas. Só que muitos exemplos citados no meu livro, é importante ressaltar, não têm nada a ver com a internet. As prisões feitas pela polícia ou as avaliações de personalidade aplicadas em professores não têm a ver estritamente com a internet. Não há como evitar que isso seja feito, mesmo que as pessoas evitem usar a internet. Mas isso foi alimentado pela tecnologia de Big Data.

Por exemplo: os testes de personalidade em entrevistas de emprego. Antes, as pessoas se candidatavam a uma vaga indo até uma determinada loja que precisava de um funcionário. Mas hoje todo mundo se candidata pela internet. É isso que gera os testes de personalidade. Existe uma quantidade tão grande de pessoas se candidatando a vagas que é necessário haver algum filtro.

BBC Brasil - Qual é o futuro do trabalho sob os algoritmos?

O'Neil - Testes de personalidade e programas que filtram currículos são alguns exemplos de como os algoritmos estão afetando o mundo do trabalho. Isso sem mencionar os algoritmos que ficam vigiando as pessoas enquanto elas trabalham, como é o caso de professores e caminhoneiros. Há um avanço da vigilância. Se as coisas continuarem indo do jeito como estão, isso vai nos transformar em robôs.

Mas eu não quero pensar nisso como um fato inevitável - que os algoritmos vão transformar as pessoas em robôs ou que os robôs vão substituir o trabalho dos seres humanos. Eu não quero admitir isso. Isso é algo que podemos decidir que não vai acontecer. É uma decisão política. Essa ideia de que os robôs vão substituir o trabalho humano é muito fatalista. É preciso reagir e mostrar que essa é uma batalha política. O problema é que estamos tão intimidados pelo avanço dessas tecnologias que sentimos que não há como lutar contra.

BBC Brasil - E no caso das companhias de tecnologia como a Uber? Alguns estudiosos usam o termo "gig economy" (economia de "bicos") para se referir à organização do trabalho feita por empresas que utilizam algoritmos.

O'Neil - Esse é um ótimo exemplo de como entregamos o poder a essas empresas da gig economy, como se fosse um processo inevitável. Certamente, elas estão se saindo muito bem na tarefa de burlar legislações trabalhistas, mas isso não quer dizer que elas deveriam ter permissão para agir dessa maneira. Essas companhias deveriam pagar melhores remunerações e garantir melhores condições de trabalho.

No entanto, os movimentos que representam os trabalhadores ainda não conseguiram assimilar as mudanças que estão ocorrendo. Mas essa não é uma questão essencialmente algorítmica. O que deveríamos estar perguntando é: como essas pessoas estão sendo tratadas? E, se elas não estão sendo bem tratadas, deveríamos criar leis para garantir isso.

Eu não estou dizendo que os algoritmos não têm nada a ver com isso - eles têm, sim. É uma forma que essas companhias usam para dizer que elas não podem ser consideradas "chefes" desses trabalhadores. A Uber, por exemplo, diz que os motoristas são autônomos e que o algoritmo é o chefe. Esse é um ótimo exemplo de como nós ainda não entendemos o que se entende por "responsabilidade" no mundo dos algoritmos. Essa é uma questão em que venho trabalhando há algum tempo: que pessoas vão ser responsabilizadas pelos erros dos algoritmos?

BBC Brasil - No livro você argumenta que é possível criar algoritmos para o bem - o principal desafio é garantir transparência. Porém, o segredo do sucesso de muitas empresas é justamente manter em segredo o funcionamento dos algoritmos. Como resolver a contradição?

O'Neil - Eu não acho que seja necessária transparência para que um algoritmo seja bom. O que eu preciso saber é se ele funciona bem. Eu preciso de indicadores de que ele funciona bem, mas isso não quer dizer que eu necessite conhecer os códigos de programação desse algoritmo. Os indicadores podem ser de outro tipo - é mais uma questão de auditoria do que de abertura dos códigos.

A melhor maneira de resolver isso é fazer com que os algoritmos sejam auditados por terceiros. Não é recomendável confiar nas próprias empresas que criaram os algoritmos. Precisaria ser um terceiro, com legitimidade, para determinar se elas estão operando de maneira justa - a partir da definição de alguns critérios de justiça - e procedendo dentro da lei.

BBC Brasil - Recentemente, você escreveu um artigo para o jornal New York Times defendendo que a comunidade acadêmica participe mais dessa discussão. As universidades poderiam ser esse terceiro de que você está falando?

O'Neil - Sim, com certeza. Eu defendo que as universidades sejam o espaço para refletir sobre como construir confiabilidade, sobre como requerer informações para determinar se os algoritmos estão funcionando.

BBC Brasil - Quando vieram a público as revelações de Edward Snowden de que o governo americano espionava a vida das pessoas através da internet, muita gente não se surpreendeu. As pessoas parecem dispostas a abrir mão da sua privacidade em nome da eficiência da vida virtual?

O'Neil - Eu acho que só agora estamos percebendo quais são os verdadeiros custos dessa troca. Com dez anos de atraso, estamos percebendo que os serviços gratuitos na internet não são gratuitos de maneira alguma, porque nós fornecemos nossos dados pessoais. Há quem argumente que existe uma troca consentida de dados por serviços, mas ninguém faz essa troca de forma realmente consciente - nós fazemos isso sem prestar muita atenção. Além disso, nunca fica claro para nós o que realmente estamos perdendo.

Mas não é pelo fato de a NSA (sigla em inglês para a Agência de Segurança Nacional) nos espionar que estamos entendendo os custos dessa troca. Isso tem mais a ver com os empregos que nós arrumamos ou deixamos de arrumar. Ou com os benefícios de seguros e de cartões de crédito que nós conseguimos ou deixamos de conseguir. Mas eu gostaria que isso estivesse muito mais claro.

No nível individual ainda hoje, dez anos depois, as pessoas não se dão conta do que está acontecendo. Mas, como sociedade, estamos começando a entender que fomos enganados por essa troca. E vai ser necessário um tempo para saber como alterar os termos desse acordo.

BBC Brasil - O último capítulo do seu livro fala sobre a vitória eleitoral de Donald Trump e avalia como as pesquisas de opinião e as redes sociais influenciaram na corrida à Casa Branca. No ano que vem, as eleições no Brasil devem ser as mais agitadas das últimas três décadas. Que conselho você daria aos brasileiros?

O'Neil - Meu Deus, isso é muito difícil! Está acontecendo em todas as partes do mundo. E eu não sei se isso vai parar, a não ser que fechem o Facebook - o que, a propósito, eu sugiro que façamos. Agora, falando sério: as campanhas políticas na internet devem ser permitidas, mas não deveriam ser permitidos anúncios personalizados, customizados - ou seja, todo mundo deveria receber os mesmos anúncios. Eu sei que essa ainda não é uma proposta realista, mas acho que deveríamos pensar grande porque esse problema é grande. E eu não consigo pensar em outra maneira de resolver essa questão.

É claro que isso seria um elemento de um conjunto maior de medidas porque nada vai impedir pessoas idiotas de acreditar no que elas querem acreditar - e de postar sobre isso. Ou seja, nem sempre é um problema do algoritmo. Às vezes, é um problema das pessoas mesmo. O fenômeno das fake news é um exemplo. Os algoritmos pioram a situação, personalizando as propagandas e amplificando o alcance, porém, mesmo que não existisse o algoritmo do Facebook e que as propagandas políticas fossem proibidas na internet, ainda haveria idiotas disseminando fake news que acabariam viralizando nas redes sociais. E eu não sei o que fazer a respeito disso, a não ser fechar as redes sociais.

Eu tenho três filhos, eles têm 17, 15 e 9 anos. Eles não usam redes sociais porque acham que são bobas e eles não acreditam em nada do que veem nas redes sociais. Na verdade, eles não acreditam em mais nada - o que também não é bom. Mas o lado positivo é que eles estão aprendendo a checar informações por conta própria. Então, eles são consumidores muito mais conscientes do que os da minha geração. Eu tenho 45 anos, a minha geração é a pior. As coisas que eu vi as pessoas da minha idade compartilhando após a eleição de Trump eram ridículas. Pessoas postando ideias sobre como colocar Hilary Clinton na presidência mesmo sabendo que Trump tinha vencido. Foi ridículo. A esperança é ter uma geração de pessoas mais espertas.

ID: {{comments.info.id}}

URL: {{comments.info.url}}

Ocorreu um erro ao carregar os comentários.

Por favor, tente novamente mais tarde.

{{comments.total}} Comentário

{{comments.total}} Comentários

Seja o primeiro a comentar

Essa discussão está encerrada

Não é possivel enviar novos comentários.

Essa área é exclusiva para você, assinante, ler e comentar.

Só assinantes do UOL podem comentar

Ainda não é assinante? Assine já.

Se você já é assinante do UOL, faça seu login.

O autor da mensagem, e não o UOL, é o responsável pelo comentário. Reserve um tempo para ler as Regras de Uso para comentários.