Governo Lula cede a lobby de empresas no PL da Inteligência Artificial

Após forte pressão empresarial, através do lobby da CNI (Confederação Nacional da Indústria) e das plataformas digitais, os ministérios da Fazenda e do Desenvolvimento, Indústria, Comércio e Serviços forçaram uma mudança de posição do governo sobre o tema da regulação da Inteligência Artificial. Atropelando uma negociação que envolveu 19 pastas do Poder Executivo, esta semana os dois ministérios uniram forças, sob o aval da Casa Civil, para dar um twist carpado nos pontos até então defendidos pelo governo Lula na negociação com o parlamento.

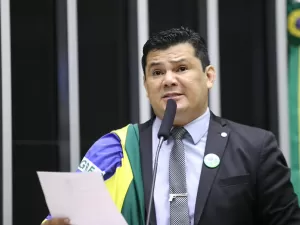

Às vésperas da apresentação do novo relatório do senador Eduardo Gomes (PL-TO), que será lido na Comissão Temporária de IA do Senado, nesta quinta (28), uma nova versão do Projeto de Lei 2338/2023, significativamente desidratada, foi "validada" em reunião interna do governo.

O último texto do relator propunha uma regulação baseada em riscos, classificando sistema de IA de acordo com tais potencialidades e gerando obrigações de mitigação correspondentes a cada nível. Ressalte-se que o primeiro relatório do senador já tinha tido a votação barrada em julho por conta dos lobbies.

Entre as obrigações, a prevenção de vieses discriminatórios por parte da IA e a explicabilidade dos sistemas - ou seja, o direito do cidadão ser informado sobre como a inteligência artificial chegou a um dado resultado ou produto. Em caso de danos causados pelos sistemas de IA, a proposta elencava direitos dos usuários e estabelecia formas de responsabilização.

Em seu discurso na reunião de Líderes do G20, em 18 de novembro, o presidente Lula colocou como central a construção de uma governança que maximize as oportunidades e mitigue os riscos da Inteligência Artificial. Meses antes, na cúpula do G7 em junho, ele havia defendido: "Interessa-nos uma IA segura, transparente e emancipadora. Que respeite os direitos humanos, proteja dados pessoais e promova a integridade da informação".

Agora, o governo vai em direção exatamente contrária à agenda de seu líder nas negociações dentro de casa sobre o tema, ajudando a desmontar uma proposta mais protetiva e responsável, que poderia tornar o Brasil referência global no tema.

Sob o discurso de que "a regulação vai impedir a inovação", CNI e empresas de tecnologia conseguiram convencer o governo que somente os sistemas de alto risco precisam ser regulados - ignorando, por exemplo, que até para entender se o risco de uma IA é alto ou não a regulação é necessária.

É só olhar para os impactos negativos em termos de discriminação racial dos sistemas de IA de reconhecimento facial, que já estão fora do texto (em São Paulo, a questão levou à suspensão do uso desse sistema no metrô). Ou de como um cidadão pode ser prejudicado pela avaliação automatizada do seu crédito no sistema financeiro, cuja regulação também caiu sob a pressão dos bancos.

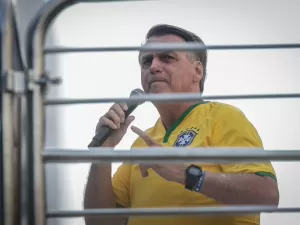

Agora, com o apoio da bancada bolsonarista, tenta-se tirar do PL a classificação de alto risco para os sistema automatizados de moderação e recomendação de conteúdos nas redes sociais. Dizem os senadores que este seria mais um "PL da Censura". Ironicamente, a Polícia Federal nos trouxe esta semana o que acontece quando a "liberdade de expressão" é tratada de forma absoluta, como cada dizendo o que quer sem se importar com a veracidade ou com as consequências: uma tentativa de golpe baseada na ideia de "fraude eleitoral" amplamente propagada nas redes.

Além de aceitar uma lei extremamente permissiva, o governo corre o risco de chancelar um texto que já pode nascer desatualizado e virar letra morta. Isso porque teria sido retirado a possibilidade de futuros sistemas de IA, ainda não desenvolvidos, virem a ser classificados como de alto risco, passando a ter que responder a um conjunto de obrigações.

A classificação seria feita pelo Sistema Nacional de Regulação e Governança de Inteligência Artificial (SIA), previsto no PL, a partir da probabilidade e gravidade dos impactos adversos sobre pessoas ou grupos afetados. Antes, o projeto adotava prática considerada fundamental em regulação de tecnologias: possibilitar que os marcos legais não fiquem desatualizados pelo dinamismo do desenvolvimento deste setor.

Agora o relatório pode vir com um rol taxativo, ou seja, uma lista fechada e limitada de quais são os sistemas de alto risco, ignorando a evolução da própria tecnologia e dos riscos que dela podem advir, e deixando futuros sistemas de IA de fora da regulação.

Que o relator Eduardo Gomes, que vem demonstrando abertura para votar uma legislação mais moderna, se veja forçado a ceder aspectos do texto para seus correligionários (partido de Bolsonaro, vale lembrar) é até compreensível. O que não é é a proposta de negociação do governo ser a mais recuada e menos protetiva sobre a mesa, excluindo uma infinidade de sistemas de IA cujos riscos sequer poderão ser conhecidos.

Organizações da sociedade civil de defesa dos direitos digitais, da integridade da informação e do jornalismo, pesquisadores e entidades de trabalhadores de diversos segmentos (incluindo os artistas, que indiscriminadamente tem suas obras surrupiadas sem qualquer conhecimento para o treinamento dos sistemas de IA) lançaram o alerta e conversaram com esta coluna.

Eles têm defendido no Congresso e no debate público a necessidade de uma regulação que garanta direitos e o desenvolvimento de uma IA responsável. Em uma semana decisiva para a democracia brasileira, será que o governo Lula realmente não percebe o tiro que pode dar no próprio pé?